Maschinelles Lernen

Die Masterarbeit untersucht die Leistungsfähigkeit von Large Language Models (LLMs) zur Extraktion strukturierter Rechnungsdaten aus PDF-Dokumenten. Der praktische Einsatzkontext ist die Berliner FinTech-Firma aifinyo AG, die monatlich rund 15.000 Rechnungen verarbeitet und eine robuste automatisierte Erfassung von Rechnungsnummer, -datum und -betrag benötigt.

Ausgangslage: Die bestehende OCR-Lösung (Gini) zeigt Schwächen bei variablen Rechnungslayouts. Die Arbeit prüft, ob LLM-basierte Verfahren eine signifikant robustere Alternative darstellen können.

Evaluierte Modelle und Strategien:

Evaluationsplattform: Es wurde eine webbasierte Plattform entwickelt, die Dokumente mit Ground-Truth verwaltet, Prompting-Strategien konfiguriert, automatisierte Ausführungen durchführt und sämtliche Metriken sowie Tokenverbrauch und Laufzeiten erfasst. Technische Basis: Ruby on Rails, PostgreSQL, einheitliche LLM-Service-API, Textextraktion mittels PDFPlumber und Tesseract.

Ergebnisse:

Fazit: LLM-basierte Methoden bieten eine klar überlegene Rechnungsdatenextraktion im Vergleich zur OCR-Lösung. In Kombination aus Genauigkeit, Layout-Robustheit und Stabilität stellt Claude 3 Sonnet mit Few-Shot-CoT den besten Ansatz dar. Empfohlen wird ein hybrides System (LLM-Hauptverarbeitung + OCR-Fallback). Potenzial zukünftiger Arbeiten: multimodale LLMs, Fine-Tuning und Kostenoptimierung.

Kolloquium: 03.11.2025

Betreuer: Prof. Dr. Emanuel Kitzelmann, Technische Hochschule Brandenburg; Prof. Dr. Roland Fassauer, CODE University of Applied Sciences

Download: A1-Poster, Abschlussarbeit

Lizenz: Creative Commons CC BY-NC-SA 4.0 - Namensnennung – Nicht kommerziell – Weitergabe unter gleichen Bedingungen 4.0 International

Der Fachbereich Informatik und Medien der Technischen Hochschule Brandenburg freut sich, Frau Prof. Dr.-Ing. Darya Kastsian zum 1. September als neue Professorin für Künstliche Intelligenz begrüßen zu dürfen.

Frau Prof. Kastsian bringt langjährige Erfahrung aus Forschung und Entwicklung mit. Unter anderem war sie seit 2015 in verschiedenen Funktionen bei der Siemens AG in Berlin tätig und entwickelte dabei Lösungen in Simulation, Künstlicher Intelligenz und Optimierung für den 3D-Druck.

Mit ihrer Berufung startet am Fachbereich die neue

Vertiefungsrichtung „Künstliche Intelligenz (KI)/Artificial Intelligence“

im Masterstudiengang Informatik. Den Auftakt bildet die von Prof.

Kastsian geleitete Veranstaltung „Deep Learning“.

Diese Bachelorarbeit im industriellen Kontext (Robert Bosch GmbH) untersucht, wie sich Sourcing Decisions (SD) mittels interpretierbarer Modelle automatisieren lassen – mit Möglichkeit zur menschlichen Intervention. Zum Einsatz kommen klassifikationsbasierte Entscheidungsbäume (Decision Trees, DT), deren Struktur und Vorhersagen nachvollziehbar bleiben sollen.

Vorgehen: Entsprechend des Data-Science-Workflows werden Rohdaten analysiert, bereinigt und aufbereitet (u. a. Umgang mit fehlenden/fehlerhaften Werten). Aus bestehenden Merkmalen werden neue Features abgeleitet, kategoriale Merkmale numerisch kodiert und numerische Merkmale in den Bereich −1 bis 1 skaliert. Das Zielmerkmal wird linear in fünf Klassen gebinnt, die das Modell später vorhersagt.

Train/Test-Split: Der verarbeitete Datensatz wird in Trainings- und Testmenge aufgeteilt; die Klassenverteilungen der Teilmengen entsprechen derjenigen des Gesamtdatensatzes und gelten damit als repräsentativ.

Hyperparameter-Tuning: Per Gridsearch werden verschiedene Setups

verglichen; das gini-Kriterium zeigt die besten mittleren

Genauigkeiten. Die Analyse der Genauigkeiten über der Baumtiefe weist ab

Tiefe 8 eine zunehmende Überanpassung aus, weshalb eine maximale Tiefe

von 7 als optimal gewertet wird. Domänenexperten bestätigen, dass das

resultierende Modell für „normale“ Fälle gut geeignet ist; für

Spezialfälle fehlen teils relevante Informationen oder deren Nutzung im

Modell.

Vergleich zu anderen ML-Ansätzen: Regressions-Entscheidungsbäume und Random-Forest-Modelle liefern leicht höhere Genauigkeiten; der Zugewinn rechtfertigt jedoch nicht den Verzicht auf die Einfachheit und Interpretierbarkeit der Klassifikations-DTs.

Fazit: Die Modellierung von Sourcing Decisions mit den vorliegenden Daten und ML ist grundsätzlich möglich. Das Modell meistert Standardszenarien, während besondere Fälle zusätzliche Merkmale bzw. Regeln erfordern.

Kolloquium: 09.09.2025

Betreuer: Prof. Dr. Emanuel Kitzelmann, Technische Hochschule Brandenburg; Marc-Alexander Frey, Robert Bosch GmbH

Download: A1-Poster

Creative Commons – CC BY-NC-SA – Namensnennung – Nicht kommerziell – Weitergabe unter gleichen Bedingungen 4.0 International

Robin Wagner, Masterstudent im Fachbereich Informatik und Medien an der THB, präsentierte im Juli 2025 ein Poster und long Paper auf dem Student Research Workshop der ACL 2025 in Wien. Sein Beitrag ist eine systematische Literaturübersicht zu Methoden, die sogenannte Halluzinationen in Antworten großer Sprachmodelle (LLMs) durch die Integration von Wissensgraphen während des Inferenzprozesses reduzieren.

Während einer intensiven 90-minütigen Postersession diskutierte er seine Ergebnisse mit einer Vielzahl neugieriger Forschender – darunter Industrievertreter, Studierende und Professor*innen mit Hintergrund in Knowledge Graphs und Retrieval-Augmented Generation (RAG). Die Atmosphäre war offen und herzlich; die Community zeigte sich außerordentlich zugänglich.

Robin dankt der Association for Computational Linguistics für diese Möglichkeit und seinen Betreuern Prof. Dr. Emanuel Kitzelmann und Dipl.-Inform. Ingo Boersch für ihre Unterstützung. Die Teilnahme vor Ort wurde durch die Technische Hochschule Brandenburg ermöglicht.

Das Paper ist online unter aclanthology.org/2025.acl-srw.53 abrufbar.

Bei der 6. Langen Nacht der Wirtschaft in der Kleeblattregion präsentierte sich das KI-Labor der Technischen Hochschule Brandenburg mit einem eigenen Stand im KMG-Klinikum in Kyritz. Vor Ort waren Professor Dr. Emanuel Kitzelmann sowie die Masterstudierenden Albert Zacher und Max Tepper, die Einblicke in ihr aktuelles Projekt zur Verbindung von KI und Robotik gaben.

Im Mittelpunkt stand der vierbeinige Roboter Unitree Go2 EDU, der mit dem Open-Source-Framework ROS 2 für autonome Navigation und Interaktion ausgestattet wurde. Die Besucherinnen und Besucher konnten sich vor Ort davon überzeugen, wie der Roboter seine Umgebung wahrnimmt und sich fortbewegt. Das Projekt wurde im Masterstudiengang Informatik durchgeführt und adressiert reale Anwendungsszenarien wie Rettungseinsätze und Wartungsaufgaben.

Der Stand war Teil einer Kooperation mit der Präsenzstelle Prignitz und bot Wissenschaft zum Anfassen für alle Altersgruppen.

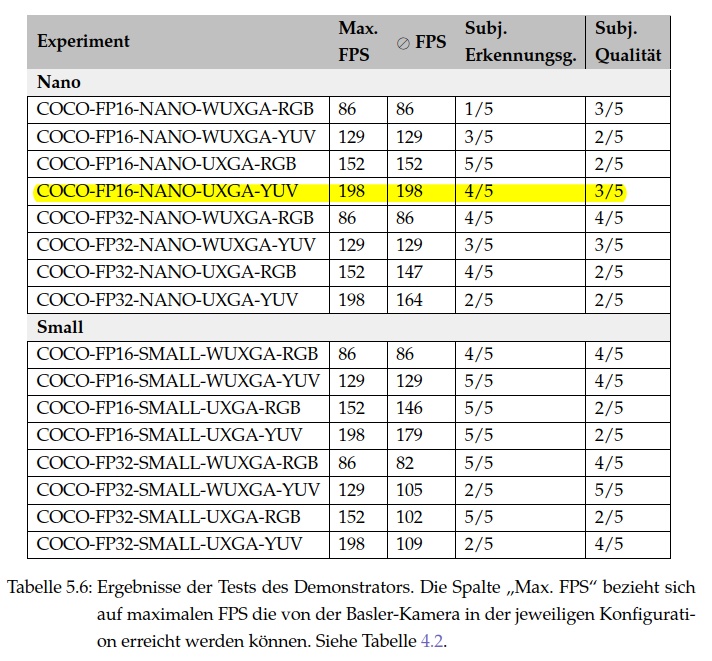

In seiner Bachelorarbeit entwickelte Lasse Broer ein performantes KI-System zur Instanzsegmentierung auf einem Jetson AGX Orin, das Bilddaten einer Basler Hochgeschwindigkeitskamera in Echtzeit mit einem YOLO-Seg-Modell verarbeitet.

Im Mittelpunkt der Arbeit stand die vollständige Installation und Konfiguration aller Komponenten sowie die Evaluation der Bildverarbeitungspipeline hinsichtlich Genauigkeit, Geschwindigkeit und Latenz. Zur Veranschaulichung entstand ein Demonstrator auf Basis von NVIDIA DeepStream, der auf einer Rampe zwei Objekte bei bis zu 198 Hz analysiert.

Das entwickelte Testframework erlaubte die gezielte Variation zentraler Parameter (Präzision, Auflösung, Modellvariante, Farbformat) zur Bewertung ihrer Auswirkungen auf die Gesamtperformance. In 16 Experimenten wurden objektive Messwerte (z. B. Latenz) und subjektive Kriterien (Segmentierungsqualität) erfasst.

Die Ergebnisse zeigen, dass eine robuste Instanzsegmentierung auf Edge-Hardware mit sorgfältiger Abstimmung möglich ist – auch bei extremen Anforderungen an Echtzeitfähigkeit und Geschwindigkeit.

Kolloquium: 31.03.2025

Betreuer: Dipl.-Inform. Ingo Boersch, Prof. Dr. Emanuel Kitzelmann

Download: A1-Poster

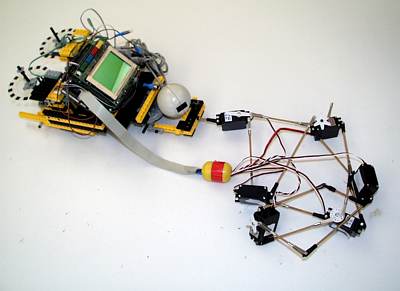

Im Rahmen seines Masterprojekts im WS24/25 entwickelte Arne Allwardt einen autonomen mobilen Roboter auf Basis des TurtleBot3 mit einem OpenManipulator-X-Arm. Ziel des Projekts war es, einen Prototypen zu realisieren, der selbstständig bestimmte Objekte an definierten Lagerplätzen aufsucht, greift und zurückbringt.

Der Roboter kartiert mit Hilfe der SLAM Toolbox seine Umgebung, lokalisiert sich über AMCL (Adaptive Monte Carlo Localization) und steuert mit Nav2 gezielt Positionen an, an denen blaue oder rote Bälle liegen. Mit Hilfe von OpenCV erkennt das System die blauen Bälle und nutzt den Manipulator, um sie zu greifen. Rote Bälle werden ignoriert.

Der Pfad zum Ziel wird über die navigate_to_pose-Action

generiert, wobei Costmaps aus Laserdaten entstehen. Für die

Interaktion von Bewegung, Wahrnehmung und Greifoperationen wurde ein MultiThreadedExecutor

verwendet. Die Steuerung basiert auf einem Zustandsautomaten, der

mit der Python-Bibliothek transitions umgesetzt wurde.

Für die Objekterkennung wurde eine Hue-basierte Farberkennung mit Erosion eingesetzt. Die größte erkannte Kontur wird als Ziel angenommen. Der Greifvorgang erfolgt blind, basierend auf Segmentierung und Kameraanalyse.

Die Navigations- und Greifvorgänge wurden in umfangreichen Szenarien getestet. Die Robustheit hängt von Faktoren wie Startposition und Beleuchtung ab – die automatische Lokalisierung konnte aber viele Störungen kompensieren. Das Video zeigt einen typischen Durchlauf.

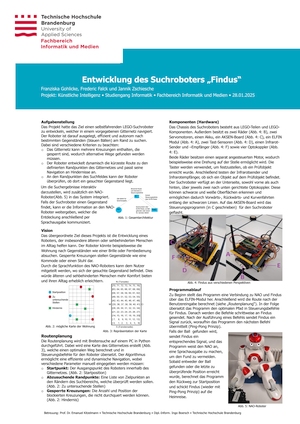

Im Projekt Künstliche Intelligenz des Wintersemesters 2024/25 entwickelten Studierende in 2- bis 3-köpfigen Teams kreative Robotiklösungen, bei denen autonome und intelligente Handlungen im Vordergrund standen. Ziel war es, Demonstratoren zu realisieren, die nicht nur technisch funktionieren, sondern auch einen Showcase-Charakter haben.

Ausgangspunkt war eine Auswahl verschiedener Robotersysteme: Turtlebots, NAOs, AKSEN-Boards, OpenManipulator-X und das leistungsstarke NVIDIA AGX Orin. Nach einer dreiwöchigen Konzeptionsphase mit intensiven Technik-Demos, individueller Betreuung und Feedback entwickelten die Teams eine eigene Projektvision mit intelligentem Verhalten – z. B. Navigation, Sprachausgabe, Objekterkennung, Planung oder Lernen.

In mehreren Zwischenetappen wurden die Prototypen realisiert, getestet und in einer Generalprobe verteidigt. Die Live-Vorführung am 15. Januar 2025, dem Tag der offenen Projekte der Bachelorstudierenden des 5. Semesters, verlief anschaulich und erfolgreich. Gezeigt wurde eine breite Palette an Anwendungen – von (physisch) mobilen Assistenten über interaktive Lernsysteme bis hin zu Echtzeit-KI auf ressourcenarmer Hardware.

Der Sortierroboter zeigt, wie mit minimaler Hardware autonome Navigation und Farbsortierung für logistische Anwendungen realisiert werden kann. Der Roboter fährt auf der Suche nach Objekten ins Lager und bringt Fundstücke je nach Farbe zu definierten Abholpunkten. Die Planung erfolgt per Breitensuche auf einem speicherschwachen AKSEN-Board (7 KB) – eine technische Herausforderung mit großem Potenzial z. B. für die Eingangssortierung in einem Warenlager.

Findus kombiniert Pfadplanung mit Sprachrückmeldung: Der Roboter durchsucht Räume nach verlegten Gegenständen und meldet sie über den NAO-Roboter per Sprache – ein Konzept für Menschen mit eingeschränktem Sehvermögen.

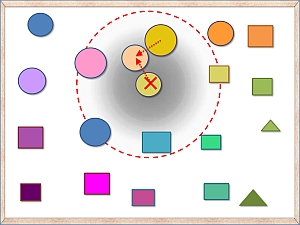

Der Dungeonmaster NAO verwandelt den Roboter in einen interaktiven Spielleiter, der Würfel erkennt und mit Nutzer*innen eine Geschichte durchlebt. Die Spiellogik ist als Automat (Abb. oben) realisiert und deklarativ in einer Excel-Tabelle hinterlegt – ein innovativer Ansatz für Lernspiele mit humanoiden Robotern.

Die Gruppe Drohnenparkour trainierte mit Teachable Machine ein neuronales Netz zur Erkennung visueller Kommandos (z. B. Richtungspfeile), die während des Flugs erkannt und ausgeführt werden. Bei Erkennungsproblemen sorgt ein Spiral-Suchmuster für robuste Ausführung. Die Anwendungsvision: intuitive Drohnensteuerung mit Symbolen statt Programmierung oder Fernbedienung – ideal für Navigation in Innenräumen oder bei Suchszenarien.

An zwei Workshoptagen, dem 06.11. und 27.11.2024, nahmen neun Mitarbeitende der ZF Getriebe Brandenburg GmbH an einer Weiterbildung zur Daten-Analyse und -Modellierung mit KNIME an der Technischen Hochschule Brandenburg teil.

In vier aufeinander aufbauenden Modulen wurden zentrale Kompetenzen zur datenbasierten Entscheidungsunterstützung vermittelt. Modul 1 bot einen Überblick über die KNIME-Oberfläche, Workflows und Best Practices. In Modul 2 stand ein konkreter Anwendungsfall aus dem Vertrieb im Zentrum, bei dem es um die Automatisierung datengetriebener Berichte ging.

Modul 3 widmete sich der Modellierung und Evaluation: Themen wie Klassifikation, einfache Metriken, Entscheidungsbäume und neuronale Netze wurden ebenso behandelt wie Deployment-Prozesse. Den Abschluss bildete ein viertes Modul mit praktischer Umsetzung der erlernten Methoden in kleinen Teams.

Die Kombination aus theoretischem Input und praxisorientierter Anwendung

kam bei den Teilnehmenden sehr gut an. Der Workshop wurde von Prof.

Dr. Georg Merz, Prof. Dr. Emanuel Kitzelmann und Ingo

Boersch durchgeführt.

Die Masterarbeit entwickelt und evaluiert ein RAG-System (Retrieval-Augmented Generation) zur teilweisen Automatisierung des Kundensupports für ein Praxisverwaltungssystem (PVS) in einem realen Unternehmen.

Die Arbeit stellt die theoretischen Grundlagen von RAG vor und nutzt diese in der Konzeptionsphase zur Variantendiskussion. Die besondere Herausforderung liegt in der Komplexität der eingesetzten Technologien und der Einbettung des Systems in den realen Anwendungskontext des Unternehmens.

Die praktische Umsetzung erfolgt durch die Entwicklung eines Chatbots mit einer REST-API in TypeScript und einer GUI in JavaScript. Die Datenbasis für den Vectorstore wird automatisch aus Confluence extrahiert und aufbereitet. Der Evaluator ist in Python implementiert. Die Evaluation des Systems erfolgt zum einen über das LangSmith Framework, das die Performance anhand verschiedener Kriterien wie Latenz, Konsistenz, Prägnanz und Relevanz der Antworten misst, und zum anderen über eine manuelle Bewertung der Antworten durch Fachexperten. Insgesamt bestätigen die Tests, dass der Chatbot die Effizienz und Qualität des Kundensupports steigern kann.

Kolloqium: 29.07.2024

Betreuer: Dipl.-Inform. Ingo Boersch, Prof. Dr. Georg Merz

Download: A1-Poster

Ingenieure und Informatiker der „ZF Getriebe Brandenburg GmbH“ nahmen am 24.04.24 und 15.05.24 an einem Workshop im Informatikzentrum der Technischen Hochschule Brandenburg teil, bei dem sie sich gemeinsam mit Prof. Dr. Georg Merz, Prof. Dr. Emanuel Kitzelmann und Ingo Boersch intensiv dem Thema „Künstliche Intelligenz“ widmeten. Ziel der Veranstaltung war es, durch die Diskussion praktischer Anwendungsfälle, die Klärung zentraler Begriffe und praktische Hands-on-Erfahrungen ein fundiertes Verständnis von KI und Data Science zu fördern.

In den Modulen wurden verschiedene anwendungsnahe Aspekte von KI und

Data Science behandelt. Ein besonderer Schwerpunkt lag auf dem letzten

Modul, das sich mit „Use Cases und praktischer Umsetzung“ befasste. Die

erfolgreiche Teilnahme wurde durch Zertifikate bestätigt. Das Feedback

der Teilnehmenden war durchweg positiv und alle waren sich einig, die

Workshopreihe und die Zusammenarbeit fortzusetzen.

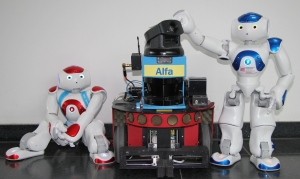

Am 01.03.2024 nahmen Prof. Kitzelmann, Prof. Pohl und Ingo Boersch für die Technische Hochschule Brandenburg am Netzwerktreffen "Roboter im Bildungskontext" an der TU Berlin teil. Ziel des Treffens war es, den Austausch über den Einsatz von Robotiksystemen als Lehrmittel zu fördern – etwa zur Vermittlung von KI-Methoden in Studium und Schule.

Die THB setzt Roboter bereits aktiv in der Lehre ein, unter anderem zur Vermittlung praxisnaher Kompetenzen im Bereich Künstliche Intelligenz. Das Netzwerk bietet dafür eine wertvolle Plattform, um Ideen, Projekte und didaktische Konzepte zu teilen. Neben der THB waren auch Vertreterinnen und Vertreter der Universität Potsdam, der Berliner Hochschule für Technik, der HU Berlin, der HTW Berlin und der Universität Paderborn beteiligt.

Besonders beeindruckend war die Präsentation von Georges A. K.

Bonga (BHT), der ein tutorielles Dialogsystem mit dem sozialen

Roboter Furhat vorstellte. Das System kombiniert GPT‑3.5-basierte

Frage-Antwort-Funktionalität mit Emotionserkennung (DeepFace) und

adaptivem Verhalten. Es wird im Rahmen seiner Masterarbeit mit dem Titel "AURALE:

Ein tutorielles System für die automatisierte Erstellung adaptiver

Lerninhalte" entwickelt. Die Arbeit wird betreut von Prof. Dr.

Martin Christof Kindsmüller (THB) und Prof. Dr. Ilona Buchem (BHT).

Im Rahmen des Masterprojektes "Künstliche Intelligenz - ChatGPT in Action" im WS23/24 wurde ein Prototyp einer Robotersteuerung entwickelt. Ziel des Projektes ist die Entwicklung und Evaluierung eines Systems zur Steuerung eines Pflegeroboters durch Kommunikation mit einem Large Language Model (LLM) am Beispiel eines rudimentären Bringeroboters. Es geht um die Untersuchung der Eignung des LLM als Schnittstelle zwischen einem Roboter und einer körperlich eingeschränkten Person, um einfache Aufgaben in der Sichtweite und unter Kontrolle des Nutzers zu übernehmen.

Die Methode zur Entwicklung des Systems umfasst den Entwurf und die Implementierung einer Testarchitektur, die aus zwei Hauptkomponenten besteht: LLM-Access zur Verwaltung der Kommunikation und RobotAPI Node zur Schnittstelle mit dem Roboter. Die Architektur basiert auf der Verwendung von ROS 2 Humble und beinhaltet ein effizientes Kontextmanagement und die Speicherung von Konversationen. Der Kommunikationsfluss beginnt mit dem Startprompt des LLM und kann iterativ zwischen Benutzeranfragen und Funktionsergebnissen wechseln.

In Praxistests wurde die Benutzbarkeit des Systems anhand eines Hindernisparcours getestet, bei dem ein simulierter turtlebot mit Laserscanner in einem slalom durch Sprachkommandos geführt wurde. Die Wege und Verzögerungen wurden aufgezeichnet.

Die Ergebnisse der Tests zeigen, dass GPT-3.5 als Schnittstelle für die Steuerung von Robotern nur bedingt geeignet ist. Positiv hervorzuheben sind die flexible Verwendung von Funktionsaufrufen und die Fähigkeit, komplexes Verhalten zu erklären. Negativ sind jedoch die hohen Verzögerungen und Missverständnisse. Die Auswertung der Praxistests ergab eine durchschnittliche Reaktionszeit von 2,3 bis 2,4 Sekunden mit Schwankungen zwischen den Durchläufen. Zur Verbesserung des Systems wird die Verwendung von Modellen mit geringerer Verzögerung und sicherheitsrelevanten Sperren empfohlen. Insgesamt zeigt das Projekt das Potenzial und die Grenzen von LLMs als Schnittstelle für die Robotersteuerung im Pflegebereich auf.

Vortrag: 08.02.2024

Betreuer: Dipl.-Inform. Ingo Boersch

Im Rahmen des Masterprojekts "Künstliche Intelligenz - ChatGPT in AKtion" im WS23/24 wurde von drei Erasmus-Studierenden ein Prototyp für einen Email-Checker entwickelt, der mit Hilfe eines Sprachmodells eine Email in Zimbra mit einem Chrome-Plugin auf Anzeichen von Phishing überprüft

Das Prinzip besteht darin, dass der Emailtext mit einem speziell entwickelten Prompt, der teilweise durch einen genetischen Algorithmus optimiert wurde, mit GPT-3.5 klassifiziert wird. Dabei berücksichtigt GPT bestimmte psychologische Aspekte [SMG22] und kann bei Bedarf auch erklären, warum die Email als Phishing erkannt wurde. Die Erkennungsrate auf einem Datensatz von Kaggle [Cha23] ist relativ hoch, fast 90% der Testmails werden korrekt als "Safe Email" oder "Phishing Email" klassifiziert. Das beste Modell hatte eine FP-Rate von knapp 7%. Das System soll Emails nicht aussortieren, sondern nur einen Warnhinweis in Form einer Ampel einblenden.

Diese Forschung trägt zum Verständnis bei, wie LLMs Cybersicherheits-Tools zum Erfolg verhelfen können. Die Bilder zeigen eine Phishing-Email und die Reaktion auf diese Email mit einer Ampel und einer Erklärung. Die Erklärung erläutert in einfachen Worten, welche Anzeichen von Phishing diese Email aufweist.

[Cha23] Chakraborty, Subhadeep: Phishing Email Detection. http://dx.doi.org/10.34740/KAGGLE/DSV/6090437. Version: 2023. https://www.kaggle.com/datasets/subhajournal/phishingemails/data

[SMG22] Shahriar, Sadat ; Mukherjee, Arjun ; Gnawali, Omprakash: Improving Phishing Detection Via Psychological Trait Scoring. 2022

Vortrag: 15.01.2024

Betreuer: Prof. Dr. Georg Merz, Dipl.-Inform. Ingo Boersch

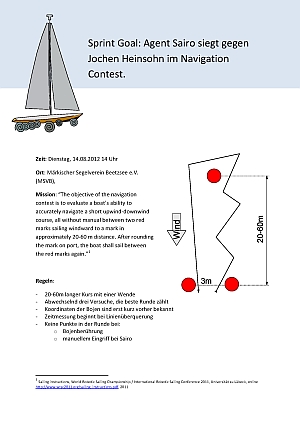

Die Arbeit im realen industriellen Kontext konzentriert sich auf die Implementierung des Domain-Adversarial Trainings neuronaler Netze (DANN) zur Überbrückung einer Domänenlücke zwischen verschiedenen Kameratypen, speziell Industriekameras und Smartphone-Kameras. Ziel der Arbeit ist es, ein Regressionsmodell zu trainieren und dieses gegen einen anderen Ansatz zu evaluieren, der Contrastive Learning for Unpaired Image-to-Image Translation (CUT) verwendet.

Die Trainingsdaten bestehen aus vorverarbeiteten Bildern von Laserschnittkanten. Um die Untersuchungen möglichst praxisnah zu gestalten, wird die Anzahl der verwendeten gelabelten und ungelabelten Bilder begrenzt. Durch die Anwendung von 3-way-holdout und einer Hyperparameter-Suche wird ein optimiertes DANN-Modell ausgewählt.

In den Ergebnissen zeigt sich, dass DANN in der Zieldomäne bessere Ergebnisse erzielt als bisherige Regressionsmodelle, jedoch die Domänenlücke nicht vollständig schließt. Bei einem Vergleich mit CUT stellt sich heraus, dass beide Ansätze ihre eigenen Vor- und Nachteile haben, sodass keine eindeutige Empfehlung ausgesprochen werden kann.

Kolloqium: 04.10.2023

Betreuer: Dipl.-Inform. Ingo Boersch, Prof. Dr.-Ing. Jochen Heinsohn, Aastha Aastha, TRUMPF SE + Co. KG

Download: A1-Poster

Die Arbeit konzentriert sich auf die Evaluation eines Word-Embedding-basierten Information-Retrieval-Systems, das von der Fraunhofer-Gesellschaft zum Patent angemeldet wurde. Ein besonderes Merkmal des IR-Systems ist die Verwendung von "SimSets" als zentrale Datenstruktur, die dazu dient, die Zeit für die Ermittlung der Suchergebnisse zu minimieren. Die Arbeit vergleicht dieses System mit einer Volltextsuche und einer durch einen domänenspezifischen Thesaurus erweiterten Volltextsuche, um deren Effektivität zu bewerten.

In der Arbeit werden drei verschiedene Evaluationsmethoden vorgestellt: Online-Evaluation, Interactive-Evaluation und die Testdatensatz-basierte Evaluation, die dann für die Untersuchung verwendet wird.

Die Ergebnisse zeigen, dass das Word-Embedding-basierte IR-System durch die Verwendung von SimSets in der Lage ist, zusätzliche Textinhalte im Vergleich zu einer herkömmlichen Volltextsuche zu ermitteln. Zudem ist die Effektivität des Systems bei einer domänenspezifischen Textsammlung vergleichbar mit einer Volltextsuche, die durch einen domänenspezifischen Thesaurus erweitert wird.

Kolloqium: 19.06.2023

Betreuer: Prof. Dr.-Ing. Jochen Heinsohn, Prof. Dr. rer. nat. Thomas Hoppe (Fraunhofer-Gesellschaft zur Förderung der angewandten Forschung e.V.)

Download: A1-Poster

Ein akustikbasiertes Prüfsystem für Steckverbindungen soll auf akustische Einflussfaktoren untersucht werden, um es prozessfähig zu integrieren. In der Vergangenheit wurden einzelne Aspekte der Realumgebung durch Feldtests betrachtet, um das System abzusichern. Ziel dieser Arbeit ist es, eine systematische Teststrategie zur Simulation von Störfaktoren auf das KI-System zu entwickeln, anzuwenden und eine Analyse basierend auf berechneten Ergebnissen durchzuführen, um das Bewertungsverhalten des Systems zu ermitteln und vorhersehbar zu machen.

Die systematische Teststrategie beinhaltet die Modifikation von Eingabedaten für das KI-System und die Erfassung von Veränderungen im Bewertungsverhalten. Für die Modifikation werden Techniken der Signalverarbeitung angewandt, um Varianz in den Daten und Einflussfaktoren auf das System zu simulieren. Techniken wie Frequenzfilterung, Tonverschiebung und Interferenz von Stör- und zu bewertenden Geräuschen sind integraler Bestandteil der Modifikationskette. Nachdem eine modifizierte Aufnahme erzeugt wurde, erfolgt eine Bewertung durch das KI-System, welches eine Liste binärer Klassifikationen und zugehörige Konfidenzwerte ausgibt. Zur Generierung analysierbarer Bewertungen wurde ein spezieller Datensatz erstellt, der aus Aufnahmen von Steckverbindungen eines bestimmten Steckertyps und verschiedenen Störgeräuschen besteht.

Die Analyse führte zu einer Rangliste der Störfaktoren, zu den für die KI-Bewertung relevanten Frequenzbereichen und zur Reaktion des Systems auf die Tonverschiebung. Die stärksten Einflussfaktoren waren das Rascheln mit ISO-Clips und einmaliges Händeklatschen. Die wichtigsten Frequenzbereiche für die Bewertung der KI lagen zwischen 4410 bis 6615 und 15434 bis 17640 Hz. Die Reaktion des Systems auf die Tonverschiebung zeigte einen Abfall der Konfidenz, wobei der Abfall bei einer Verschiebung in den hochfrequenten Bereich stärker war. Durch die Analyse konnten Funktionen erstellt werden, die die Reaktion der KI auf verschiedene Einflüsse beschreiben, und somit konnte das Erreichen von Bewertungsgrenzen vorhergesagt werden.

Kolloqium: 26.01.2023

Betreuer: Dipl.-Inform. Ingo Boersch, Prof. Dr.-Ing. Jochen Heinsohn, Philipp Stephan (M.Sc.), Dipl.-Ing. (FH) Marcel Preibisch (Mercedes-Benz AG)

Download: A1-Poster

Die Aufgabe besteht darin, einen systematischen Review über die Erkennung von Gebärdensprachen durchzuführen, um einen Überblick über die vorhandenen Gebärdensprachenerkennungstechnologien zu geben. Die Forschungsfrage lautet: "Welche Anwendungen mit welchen Bedingungen weisen die visuellen Gebärdensprachenerkennungen auf?" Die Arbeit konzentriert sich auf Technologien, die Kameras verwenden, um Gebärden zu erfassen, und zielt darauf ab, praktisch umsetzbare Anwendungen herauszuarbeiten und deren Umsetzungsvoraussetzungen zu definieren.

Die Literatur wird mithilfe von Suchmaschinen und dem booleschen Suchverfahren gesucht. Die Auswahl der Literatur erfolgt anhand von festgelegten Ein-, Ausschluss- und Qualitätskriterien. Die Einschlusskriterien beinhalten, dass die Literatur im Jahr 2022 veröffentlicht wurde, auf Deutsch oder Englisch verfasst ist, aus dem Informatikbereich stammt und dynamische visuelle Eingaben der Technologien beinhaltet. Das Ausschlusskriterium exkludiert das Erkennen von Gesten, die nicht zu einer Gebärdensprache gehören. Die Qualitätskriterien bewerten, wie akkurat eine Quelle ihre Ergebnisse darstellt. Die ausgewählten Artikel werden nach Qualitätspunkten sortiert und diejenigen mit einer Punktzahl von über vier werden für den Review verwendet.

Die ausgewählten Literaturen stellen Technologien vor, die zwischen sechs und 1295 Klassen erkennen können und Sprachen wie Englisch, Chinesisch, Argentinisch, Deutsch und Indonesisch erkennen können. Die Erkennung geschieht entweder zu isolierten Wörtern oder zusammenhängenden Gebärden. Es fehlen jedoch oft Angaben, die wichtig zur Bestimmung der Anwendbarkeit sind, wie zum Beispiel die benötigte Rechenleistung. Mit bestimmten Annahmen könnten fünf der Technologien in Bereichen wie Infopunkten oder Apps einsetzbar sein. Es wird festgestellt, dass die Quellen keine deutlichen Anwendungen für die vorhandenen Gebärdensprachenerkennungen definieren, aber mit guter Qualität der Quelle lassen sich Schlüsse auf mögliche Einsatzfelder der Technologien ziehen.

Kolloqium: 07.10.2022

Betreuer: Prof. Dr. Rolf Socher, Dipl.-Inform. Ingo Boersch

Download: A1-Poster

Ziel der Arbeit ist die Entwicklung eines künstlichen Bewegungsapparates für virtuelle Kreaturen (sog. „Swimbots“), welches aufbauend auf dem KipEvo-Projekt in einer in Unreal Engine implementierten Simulationsumgebung der Evolution unterzogen werden. Die Wirksamkeit der Swimbots wird durch Experimentdurchläufe untersucht und diskutiert.

Konzept

Die Swimbots werden als Mehrkörpersystem mit mehreren kinematischen Ketten modelliert. Die Drehmomente der Gelenke werden durch ein neuronales Netz berechnet, das auf vielfältige Eingangsreize aus externen und Propriozeptoren reagiert. Die ausgabe der Drehmomente erfolgt in die Physik-simulation der Enreal Engine. Sowohl die Körperbeschreibung (Baum) als auch die Wichtungen des neuronalen Netzes werden in der Evolution durch genetische Operatoren 8Mutation) verändert, so dass neuartige Individuen entstheen, die ebenfalls am Wettstreit um Futter teilnehmen.

Jede virtuelle Kreatur wird aus einem Genotyp gebildet, in welchem Basiseigenschaften (wie z.B. die Sichtfähigkeit oder Reproduktionseigenschaften), die Körperstruktur und genexpressive Eigenschaften in Form einer JSON-Struktur gespeichert sind. Diese bilden die Grundlage für die Verhaltensweise, sowie den Körperbau der Individuen ab. Eine erfolgreiche Evolution der Swimbots hängt von der Zusammensetzung dieser Eigenschaften sowie der sich daraus bildenden Anpassungsfähigkeit ab. Durch asexuelle Reproduktion sind die Swimbots in der Lage Nachkommen zu erzeugen. Dies wird durch die Aufnahme von Energie erreicht, welche die Swimbots in Form von Nahrungsobjekten in der Simulationswelt aufsammeln können. Eine geeignete Bewegungsmechanik, durch welche eine Fortbewegung zur Nahrung ermöglicht wird, sorgt für das Überleben der Kreatur.

Durch das integrierte Ökosystem können Eigenschaften beeinflusst werden, wodurch sich der Evolutionsverlauf der Swimbots verändern kann. Die simulation kann unter Beibehaltung der Physikmodellierung bis zu 10fach beschleunigt werden.

Kolloqium: 13.09.2022

Betreuer: Dipl.-Inform. Ingo Boersch, Prof. Dr.-Ing. habil. Michael Syrjakow

Download: A1-Poster, Abschlussarbeit

Im Rahmen dieser Bachelorarbeit wird der Greifarm OpenManipulator-X der Firma ROBOTIS in Betrieb genommen. Der OpenMANIPULATOR-X ist ein Greifarm der Firma ROBOTIS, der mit dem Robot Operating System 2 (ROS2) betrieben wird. Für diese Arbeit wird er auf einer stationären Basisplatte montiert. Alternativ besteht die Möglichkeit ihn auf dem mobilen Roboter TurtleBot3 WafflePi zu montieren.

Es werden ein Überblick über die grundsätzlichen Vorgänge und Prozesse bei dessen Nutzung gegeben sowie die Möglichkeiten der Steuerung erprobt. Weiterhin wird die Steuerung mittels Handlungsplanung ermöglicht. Hierzu ist der Stand der Forschung auf dem Gebiet der automatischen Handlungsplanung dargestellt. Als geeignetes Planungsverfahren wird "Partial Order Planning Forward" implementiert und einem selbstgewählten Szenario (Blöckewelt) praktisch demonstriert.

Kolloqium: 24.02.2022

Betreuer: Prof. Dr.-Ing. Jochen Heinsohn, Dipl.-Inform. Ingo Boersch

Download: A1-Poster, Abschlussarbeit

Generative Adversarial Networks (GANs) sind ein aktueller Ansatz im Bereich der Deep Neural Networks. Diese Netzwerke sind in der Lage anhand von hochdimensionalen Trainingsdaten (speziell Bildern) die Verteilung der Daten zu erlernen und erfolgreich Generatoren für diese Verteilung hervorzubringen. Das Ziel dieser Arbeit besteht in der Auswahl, Implementierung und Evaluation moderner GANs zur Synthese von Bildern menschlicher Gesichter. Die besondere Schwierigkeit besteht in der Erschließung und Komplexität der theoretischen Grundlagen, einer korrekten Implementierung und insbesondere in der Auswahl und Umsetzung geeigneter Evaluationsverfahrens zur Beurteilung der Güte der Generatoren.

Im Rahmen der Arbeit wurden drei bekannte GAN-Modelle SGAN, DCGAN, und WGAN-GP implementiert. Die Implementierung erfolgte in der Programmiersprache Python mit PyTorch. Zur Visualisierung der Ausgabe-Daten und der Ergebnisse wurde TensorBoard verwendet. Das Training der GAN-Modelle wurde auf einer NVIDIA Titan RTX Grafikkarte mit CUDA 11.1 durchgeführt.

Die Qualität der durch SGAN, DCGAN und WGAN-GP generierten Bilder wurde qualitativ und quantitativ überprüft. Die Fréchet Inception Distance (FID) Metrik wurde implementiert und für die quantitative Bewertung verwendet. Die qualitative Evaluierungsmethode erfolgt objektiv und auf menschlicher Basis. Hierfür wurde das Konzept der Rapid Scene Categorization-Methode verwendet. Beide Bewertungsmethoden zeigten, dass das DCGAN-Modell bessere Bilder als WGAN-GP- und SGAN-Modell erzeugt.

Kolloqium: 10.02.2022

Betreuer: Dipl.-Inform. Ingo Boersch, Prof. Dr.-Ing. Jochen Heinsohn

Download: A1-Poster,, Abschlussarbeit

Das Ziel dieser Bachelorarbeit liegt in der Gegenüberstellung von mindestens zwei Frameworks zum Management von Data Science-Experimenten. Hierbei ist der Bedarf, die Szenarien, die Einsatzbereiche und funktionalen Angebote derartiger Frameworks theoretisch zu erarbeiten und an einem konkreten Beispiel (mindestens Klassifikation mit Hyperparameteroptimierung) mit Blick auf die Nutzung in einem KMU zu evaluieren.

Eine wichtige nichtfunktionale Anforderung ist die Verständlichkeit, Nachvollziehbarkeit und Wiederholbarkeit der Arbeit.

In der Arbeit werden die Frameworks Neptune.ai und Comet.ml gegenübergestellt. Nach den theoretischen Grundlagen zu MLP, CNN und Experimentverwaltung, werden die beide Frameworks anhand von ausgewählten Kriterien verglichen.

Im praktischen Teil der Bachelorarbeit werden Experimente zur Bildklassifizierung mit dem MNIST-Datensatz mit MLP und CNN in beiden Frameworks durchgeführt und verglichen. Die Unterschiede der beiden Frameworks werden in den Experimenten anhand bestimmter Kriterien wie Versionskontrolle, Abhängigkeitsmanagement, Datenversionierung, Modellversionierung, Modellregistrierung, Artefakten laden und Proto kollierung von Metadaten untersucht.

Kolloqium: 07.02.2022

Betreuer: Dipl.-Inform. Ingo Boersch, Prof. Dr.-Ing. Jochen Heinsohn

Download: A1-Poster

Ziel der Arbeit sind Deep Learning-Methoden aus dem Stand der Forschung und ihre Implementierungen zur Detektion von Kanus und Ruderbooten in Zeilenkamera-Bildern. Hierzu sollen geeignete Ansätze identifiziert, exemplarisch auf dem Deep Learning-Server des Fachbereiches mit den Kanudaten trainiert, evaluiert und mit den im Einsatz befindlichen Netzversionen verglichen werden. Eine Detektion auf der Zielplattform Jetson Nano ist optional, sollte aber berücksichtigt werden.

Schwerpunkte sind die Darstellung der Funktionsweise eines sinnvoll gewählten Modells, des Vorgehens beim Training, bei der Hyperparameteroptimierung und beim Vergleich mit den Vorgängermodellen. Eine wichtige nichtfunktionale Anforderung aus Sicht des Unternehmens ist die Verständlichkeit, Nachvollziehbarkeit und Wiederholbarkeit der Arbeit.

Kolloqium: 18.02.2022

Betreuer: Dipl.-Inform. Ingo Boersch, Prof. Dr.-Ing. Jochen Heinsohn, Dipl.-Inform. (FH) Daniel Schulz (IMAS Startanlagen und Maschinenbau)

Download: A1-Poster

Ziel der Arbeit ist die Untersuchung von Methoden des maschinellen Lernens zur Prognose von Qualitätsmaßen bei der Produktion von Spritzgussteilen. Die Arbeit ist eine erste Arbeit in diesem Kontext im Unternehmen und übernimmt somit eine Pilotfunktion. Das umfasst den kompletten Data Mining-Prozess von der Datenerfassung, -bereinigung, -aggregation, -vorverarbeitung und -exploration, der Definition geeigneter Gütemaße, Entwicklung eines Evaluationskonzeptes, über das Erstellen, Bewerten und Optimieren von Modellen, bis hin zur Modellselektion und nachhaltigen Dokumentation. Schwerpunkt ist das exemplarische Absolvieren aller notwendigen Schritte bis zu einem Modellvorschlag mit prognostizierter Güte.

Hierzu sind geeignete Anforderungen zu formulieren und ein sinnvoller Evaluationsprozess umzusetzen, der die erwartete Leistung der Regressoren bestimmt. Eine wichtige nichtfunktionale Anforderung aus Sicht des Unternehmens ist die Verständlichkeit, Nachvollziehbarkeit und Wiederholbarkeit der Arbeit.

Kolloqium: 28.10.2021

Betreuer: Dipl.-Inform. Ingo Boersch, Prof. Dr. Jochen Heinsohn, Dipl.-Ing. Stefan Lehmann (Kunststoff-Zentrum in Leipzig gGmbH)

Download: A1-Poster, Abschlussarbeit

Ziel dieser Arbeit war die Untersuchung von Methoden des maschinellen Lernens für die Klassifizierung bzw. Distinktion von Fake News und echten Nachrichtenmeldungen. Einen besonderen Aspekt nimmt dabei der Faktor Transparenz ein. Untersucht wurden drei tiefe neuronale Netze und ein Modell basierend auf der logistischen Regression, sowie die Generierung von Erklärungen post-hoc mittels LIME. Die Untersuchungen wurden für drei verschiedene Datensätze vorgenommen.

Die Ergebnisse zeigen, dass die Genauigkeit der Modelle stark von dem zugrundeliegenden Datensatz abhängt. Mittels LIME konnten Erklärungen dafür gefunden werden. So finden sich in einem Datensatz Wörter, die immer in der Klasse „echte Nachrichtenmeldung“ zu finden sind. Die Modelle haben gelernt, dass es diesen Zusammenhang gibt und die Artikel anhand dieser Eigenschaften sortiert. Folglich konnten dadurch keine robusten Eigenschaften zur Unterscheidung der Klassen gelernt werden.

Kolloqium: 02.08.2021

Gutachter: Prof. Dr. Sven Buchholz, Dipl.-Inform. Ingo Boersch

Download: A1-Poster

Die Arbeit untersucht das Deployment vortrainierter Detektoren zur Erkennung von Boundingboxen und pixelgenauen Instanzen auf die Plattform Jetson Nano. Hierzu sind geeignete vortrainierte Netze zu evaluieren, weiter zu trainieren und optimiert auf dem Zielsystem auszuführen. Die Optimierung kann auf dem Trainingsserver oder auf dem Zielsystem stattfinden. Die Detektoren sollen in allen drei Phasen durch sinnvolle Metriken auf einer selbstgewählten Datenmenge evaluiert werden. Die lauffähige Umsetzung eines selbst trainierten Detektors auf dem Jetson Nano ist durch eine einfache Rahmenapplikation mit dem Deepstream SDK im Funktionsnachweis zu demonstrieren. Die besondere Schwierigkeit besteht in der Vielzahl beteiligter Frameworks, wie bspw. DeepStream, Triton, CUDA, gsstreamer, TensorFlow, TensorRT, Django, WSGI, Kafka und anderen sowie der Anwendung fortgeschrittener Modelle des Deep-Learnings, wie YOLO, SSD und Mask R-CNN.

Im Ergebnis konnten die Netze erfolgreich auf dem Deep-Learning-Server der Hochschule weitertrainiert und in verschiedenen Kriterien mit den Originalen verglichen werden. Die Optimierung erfolgte auf dem Trainingsserver und zeigte nur wenig Verbesserungen, beim Deployment auf das eingebettete Systeme wurden verschiedene Probleme mit TensorRT (TF-TRT) festgestellt. Die Rahmenapplikation auf dem Jetson Nano demonstriert ein lokales SSD zur Objektdetektion der COCO-Klassen, dessen Ergebnisse über RTSP- und Kafka bereitgestellt werden.

Kolloqium: 13.04.2021

Betreuer: Dipl.-Inform. Ingo Boersch, Prof. Dr. Sven Buchholz

Download: A1-Poster

Ziel der Arbeit ist die Untersuchung des Einflusses verschiedener Kodierungen der Farbinformation bei der Klassifikation medizinscher Bilder mit Deep Learning-Modellen. Die Bilder stammen aus einem Operationsszenario der Gallenblasenentfernung und zeigen einzelne oder mehrere Operationswerkzeuge im Körper bei minimalinvasiver Chirurgie. Hierzu sind die Kodierungen zu bestimmen, die Datenmenge vorzuverarbeiten, geeignete Pipelines zur Modellentwicklung und -evaluation zu realisieren und die Ergebnisse auszuwerten. Die besondere Schwierigkeit besteht in der Größe der Datenmenge, der Einarbeitung in das Gebiet der Bildklassifikation mit Convolutional Neural Networks und dem korrekten Umsetzen eines sinnvollen Evaluierungskonzeptes.

Im Ergebnis entstand gelungene Modellierung der Bildklassen unter Berücksichtigung der Besonderheiten der Datenmenge. Die anschauliche Interpretation der Fehlklassifikationen deckte Probleme in der Grundwahrheit Cholec80 auf.

Kolloqium: 13.04.2021

Betreuer: Dipl.-Inform. Ingo Boersch, Prof. Dr. Jochen Heinsohn, Dr. rer. nat. Florian Aspart (caresyntax GmbH)

Download: A1-Poster, Abschlussarbeit

Genetische Algorithmen (GA) können zur Optimierung der Wichtungen künstlicher neuronaler Netze (kNN) verwendet werden. Die Lernaufgabe ist in diesem Fall das Finden einer Policy, die in der Lage ist, in einer einfachen simulierten Umgebung ein Fahrzeug zu steuern und gehört damit zum Reinforcement-Learning. Hierzu ist der GA zu implementieren und auf die Lernaufgabe anzuwenden. Die (physikbasierte) Simulation ist in geeigneter Weise in Unity zu entwickeln und soll Aspekte der Vermittlung von Konzepten berücksichtigen. Dies wäre denkbar durch die Visualisierung der Genotypen, der Fitnessverteilung oder der Fitnessentwicklung. Die besondere Schwierigkeit besteht in der Entwicklung einer Gesamtapplikation mit Simulation, Prozess-Steuerung, Visualisierung und KI-Komponente.

Im Ergebnis entstand eine anschauliche, motivierende Unity/C#-Applikation, die eine Population von neuronalen Netzen als Policy für die Steuerung der Fahrzeuge evolviert. Die Evolution kann mittels Fitnessverteilung und Fitnesskurven über die Generationen verfolgt werden. Die Verwandschaftsverhältnisse werden durch Farbcodes im Genotyp verdeutlicht. Trainierte Populationen können dann auf andere Strecken übertragen werden und zeigen dort eine ähnlich gute Leistung.

Kolloqium: 29.03.2021

Betreuer: Dipl.-Inform. Ingo Boersch, Prof. Dr. Jochen Heinsohn

Download: A1-Poster, Abschlussarbeit

In den letzten Jahren hat die Edge-KI, d.h. die Übertragung der Intelligenz von der Cloud in Edge-Geräte wie Smartphones und eingebettete Systeme an großer Bedeutung gewonnen. Dies erfordert optimierte Modelle für maschinelles Lernen (ML), die auf Computern mit begrenzter Rechenleistung funktionieren können. Die Quantisierung ist eine der wesentlichen Techniken dieser Optimierung. Hierbei wird der Datentyp zur Darstellung der Parameter eines Modells verändert. In dieser Arbeit wurde die Quantisierung untersucht, insbesondere die Quantisierungstechniken nach dem Training, die in TensorFlow Lite (TFLite) verfügbar sind. Ein auf dem MNIST- Datensatz trainiertes Bildklassifizierungsmodell und ein auf dem Cityscapes-Datensatz trainiertes semantisches Segmentierungsmodell wurden für die Durchführung von Experimenten eingesetzt. Für das Benchmarking wurde die Inferenz auf zwei Hardware-unterschiedlichen CPU-Architekturen ausgeführt, und zwar auf einem Laptop und einem Raspberry Pi. Für das Benchmarking wurden Metriken wie Modellgröße, Genauigkeit, mittlere Schnittmenge über Vereinigung (mIOU) und Inferenzgeschwindigkeit gehandhabt. Sowohl für Bildklassifizierungs- als auch für semantische Segmentierungsmodelle zeigten die Ergebnisse eine erwartete Verringerung der Modellgröße, wenn verschiedene Quantisierungstechniken angewendet wurden. Genauigkeit und mIOU haben sich in beiden Fällen nicht wesentlich von der des Originalmodells geändert. In einigen Fällen führte die Anwendung der Quantisierung sogar zu einer Verbesserung der Genauigkeit. Dabei hat sich die Inferenzgeschwindigkeit bezüglich des Bildklassifizierungsmodells adäquat verbessert. In einigen Fällen erhöhte sich die Inferenzgeschwindigkeit auf Raspberry Pi sogar um den Faktor 10.

Kolloqium: 02.03.2021

Betreuer: Prof. Dr.-Ing. Jochen Heinsohn, Abhishek Saurabh (MSc) Volkswagen Car.Software Organization, Dipl. Inform. Ingo Boersch

Download: A1-Poster, Bachelorarbeit

Die Kreditwürdigkeitsprüfung ist ein wichtiger Schritt, der von Kreditvergabestellen durchgeführt wird und der darüber entscheiden kann, ob das Bankinstitut potenziellen Kreditnehmern einen Kredit gewährt oder nicht. Diese Prüfung hat einen großen Einfluss auf Agenturen, insbesondere im Finanzsektor. Um finanzielle Probleme zu vermeiden, die aufgrund von Risiken bei der Kreditvergabe auftreten, wird eine Methode benötigt, die die Kreditwürdigkeitsprüfung unterstützt, indem die statistische Leistung eines Kreditscoring-Modells erhöht wird. Mit Hilfe von maschinellen Lernmodellen können Zeit, Aufwand und Kosten für die Durchführung statistischer Analysen, die auf Big Data angewendet werden, reduziert werden. Aus diesem Grund werden in dieser Arbeit Algorithmen des maschinellen Lernens, namentlich von Logistic Regression, K-Nearest Neighbors und Support Vector Machine, verglichen. Ferner werden Experimente durchgeführt, die die Leistung dieser Modelle verbessern können.

Kolloqium: 11.02.2021

Betreuer: Prof. Dr. Jochen Heinsohn, Dipl.-Inform. Ingo Boersch

Download: A1-Poster

Bayessche Netze (BN) sind gut zur Modellierung von Unsicherheit geeignet. Ein aktuelles Beispiel für das Auftreten von Unsicherheit ist die COVID-19 Domäne, insbesondere die Zusammenhänge zwi- schen u.a. Symptomen, Analysen, Auswirkungen und Folgen. Nach einer kurzen Einführung in die Grundlagen der BN sollen die we- sentlichen Konzepte der COVID-19 Domäne einschließlich ihrer Zu- sammenhänge dargestellt werden. Eine Analyse zum Stand der Forschung zu BN, die genau diese Domäne bereits als Anwendung haben, schließt sich an, ebenfalls eine eigene kurze Bewertung. Kern der Bachelorarbeit ist eine eigene Umsetzung mit Hilfe des HUGIN-Tools.

Die entstandene Anwendung ermöglicht es, die Wahrscheinlichkeit einer Erkrankung an COVID-19, SARS, MERS oder Influenza zu bestimmen. Dafür werden die beobachteten Symptome dem Netz als Evidenz bekannt gemacht. Das heißt, der Wert der entsprechenden Variable wird festgelegt und ist nicht mehr abhängig von der ursprünglichen Wahrscheinlichkeit. Es lässt sich zeigen, dass spezifische Symptome, wie die Störung des Geschmacks und/oder Geruchssinns, die A- posteriori-Wahrscheinlichkeiten der Krankheiten stärker beeinflussen als häufige Symptome wie Husten.

Kolloqium: 11.02.2021

Betreuer: Prof. Dr. Jochen Heinsohn, Dipl.-Inform. Ingo Boersch

Download: A1-Poster

Diese Arbeit stellt Probleme und Lösungen vor, die auftreten können, wenn mit großen unstrukturierten Datensätzen gearbeitet wird. Dies erfolgt am Praxisbeispiel, die über die Zeit verwendeten JavaScript-Bibliotheken aus dem CommonCrawl-Datensatz zu extrahieren. Beginnend mit wenigen Hardware-Ressourcen und dem späteren Einsatz der stärkeren Infrastruktur des Future SOC Labs werden die verschiedenen Probleme, die diese Entwicklungsstadien mit sich bringen, behandelt, bspw. knappe Ressourcen zum Betreiben der Datenbank und die Hardwarekonfiguration. Abschließend werden die gesammelten Erkenntnisse anhand eines Teils des Datensatzes für das Praxisbeispiel umgesetzt und die Ergebnisse visualisiert. Die Einschränkung auf nur einen Teil des Datensatzes resultiert daraus, dass mit der vorhandenen Hardware der komplette Datensatz nicht bearbeitet werden kann.

Kolloqium: 23.10.2020

Betreuer: Prof. Dr. Sven Buchholz, Dipl. Inform. Ingo Boersch

Download: A1-Poster

In diesem Teilprojekt geht es um die Simulation von Evolution in einem künstlichen ökologischen System. Das langfristige Ziel ist eine anschauliche Visualisierung verschiedener Evolutionsphänomene wie bspw. Gendrift, mehrkriterielle Optimierung, dynamische Fitnesslandschaften, Koevolution, konvergente Evolution und andere. Diese Effekte sind in der Natur wegen ihrer Verteiltheit und Langsamkeit schwer zu beobachten und sollen hier durch Individuen in einer 3D-Welt erlebbar werden. Es soll Spaß machen, den Experimenten wie einem spannenden Film zu folgen. Das Projekt orientiert sich an der 2D-Welt in [1].

Phase 1: Schließen der Evolutionsschleife in einer einfachen Ökologie

Lauffähiger Prototyp mit Genotypen, Phänotypen, Bewegung, Mutation, Vererbung und Futter (UnrealEngine, C++ und Blueprint)

Quelltext und Exe auf Anfrage an boersch@th-brandenburg.de.

[1] Ventrella J. (2005) GenePool: Exploring the Interaction Between Natural Selection and Sexual Selection. In: Adamatzky A., Komosinski M. (eds) Artificial Life Models in Software. Springer, London. https://doi.org/10.1007/1-84628-214-4_4

Ziel der Arbeit sind erste Schritte zur Erweiterung einer Angebotsplattform für Leasingverträge um ein Vorschlagssystem. Das bisherige System benutzt einen sog. Dienstwagenrechner (DWR), um die monatliche Kostenbelastung für vom Nutzer einzugebende Vertragsdaten zu berechnen. Die Berech-nung ist zeitaufwändig. Durch eine Beschleunigung des DWR könnte die Zielgröße schon bei teilweise eingegebenen Vertragsdaten für eine Vielzahl von Optionen, bspw. Fahrzeugtypen, berechnet wer-den und somit als Grundlage für einen Vorschlag eines Vertragsmerkmals dienen. Diese Arbeit ver-sucht das Ziel durch eine datenbasierte Approximation des DWR zu erreichen. Die Hauptziele der Arbeit sind somit:

Eine Schwierigkeit der Aufgabe besteht in der Einbettung in einen realen Unternehmenskontext, sowie in der besonderen Situation der COVID-Pandemie.

Kolloqium: 09.07.2020

Betreuer: Dipl. Inform. Ingo Boersch, Prof. Dr. Susanne Busse

Download: A1-Poster

Eine erfolgreiche Kombination von Imitation Learning (IL) und Reinforcement Learning (RL) zur Bewegungssteuerung eines Roboters besitzt das Potenzial, einem Endnutzer ohne Programmierkenntnisse einen intelligenten Roboter zu Verfügung zu stellen, der in der Lage ist, die benötigten motorischen Fähigkeiten von den Menschen zu erlernen und sie angesichts der aktuellen Rahmenbedingungen und Ziele eigenständig anzupassen. In dieser Masterarbeit wird eine Kombination von IL und RL zur Bewegungssteuerung des humanoiden Roboter NAO eingesetzt. Der Lernprozess findet auf dem realen Roboter ohne das vorherige Training in einer Simulation statt. Die Grundlage für das Lernen stellen kinästhetische Demonstrationen eines Experten sowie die eigene Erfahrung des Agenten, die er durch die Interaktion mit der Umgebung sammelt.

Das verwendete Lernverfahren basiert auf den Algorithmen Deep Deterministic Policy Gradient from Demonstration(DDPGfD) und Twin Delayed Policy Gradient (TD3) und wird in einer Fallstudie, dem Spiel Ball-in- a-Cup, evaluiert. Die Ergebnisse zeigen, dass der umgesetzte Algorithmus ein effizientes Lernen ermöglicht. Vortrainiert mit den Daten aus Demonstrationen, fängt der Roboter die Interaktion mit der Umgebung mit einer suboptimalen Strategie an, die er im Laufe des Trainings schnell verbessert. Die Leistung des Algorithmus ist jedoch stark von der Konfiguration der Hyperparameter abhängig. In zukünftigen Arbeiten soll für das Ball-in- a-Cup-Spiel eine Simulation erstellt werden, in der die Hyperparameter und die möglichen Verbesserungen des Lernverfahrens vor dem Training mit dem realen Roboter evaluiert werden können.

Kolloqium: 22.01.2020

Gutachter: Dipl.-Inform. Ingo Boersch, Prof. Dr.-Ing. Jochen Heinsohn

Download: A1-Poster, Masterarbeit

Interessante Schlagzeugrhythmen zu finden ist eine kreativ anspruchsvolle Aufgabe. Es gibt die Möglichkeiten verschiedene Instrumente zu verschiedenen Zeitpunkten zu spielen. Die Anordnung der zu spielenden Instrumente in einem Zeitverlauf muss dabei wiederholbar sein und dem Schlagzeuger gefallen. Zur Unterstützung bei diesem Prozess werden interaktive evolutionäre Algorithmen vor- geschlagen. Durch die Interaktivität kann der Nutzer die Suche steuern und die Abwand- lungsoperatoren des evolutionären Algorithmus erzeugen neue Vorschläge. Ein Schwerpunkt dieser Arbeit liegt auf der Benutzeroberfläche. Diese soll die Ermüdung des Nutzers gering halten und auch zur Nachvollziehbarkeit des evolutionären Algorithmus beitragen. Theoretische Grundlagen werden erläutert, inspirierende Arbeiten betrachtet, die Konzep- tion und Umsetzung eines Demonstrationsprogramms beschrieben und Versuche mit dem Programm dokumentiert und ausgewertet.

Evolutionäre Algorithmen sind Optimierungsverfahren, die von der Evolution von Lebewesen inspiriert sind. Es werden Lösungsvorschläge (Individuen) erzeugt, die eine Bewertung (Fitness) zugeordnet bekommen, auf deren Grundlage eine Auswahl (Selektion) stattfindet welche Individuen zur Erzeugung der nächsten Individuen genommen werden. Die Kodierung eines Individuums ist der Genotyp, die Erscheinungsform des Individuums ist der Phänotyp. Wenn es eine Mensch-Maschine-Schnittstelle gibt, dann handelt es sich um einen interaktiven evolutionären Algorithmus nach der erweiterten Definition aus [Tak01]. Die Inklusion des Menschen in den Prozess stellt den Schwachpunkt dieser Vorgehensweise dar, da Menschen durch gleichbleibende Tätigkeiten schnell ermüden. Außerdem stellt das Vergleichen mehrerer zeitsequenzieller Individuen eine besondere kognitive Belastung des Nutzers dar.

[Tak01] Takagi, H.: Interactive evolutionary computation: fusion of the capabilities of EC optimization and human evaluation. In: Proceedings of the IEEE 89 (2001), Nr. 9. http://dx.doi.org/10.1109/5.949485. – DOI 10.1109/5.949485

Kolloqium: 29.10.2019

Gutachter: Dipl.-Inform. Ingo Boersch, Prof. Dr. Martin Christof Kindsmüller

Download: A1-Poster, Masterarbeit

Bei dieser Arbeit sollen anonymisierte, aufgezeichnete Motorradtouren (Tracks) von calimoto Nutzern analysiert werden, um daraus zu ermitteln, wie häufig Motorradfahrer auf welchen Straßen gefahren sind. Daraus soll ein neues Routingprofil erstellt werden, welches Routen über die populärsten Straßen generieren soll. Evaluiert wird auch, ob die Integration der Häufigkeitswerte in die Routenplanung nützlich ist und diese für Motorradfahrer geeignete Routen generiert.

Kolloqium: 18.09.2019

Betreuer: Prof. Dr.-Ing. Jochen Heinsohn, Sebastian Dambeck M.Sc. (calimoto GmbH), Dipl.-Inform. Ingo Boersch

Download: A1-Poster

Die Arbeit untersucht exemplarisch die Leistzungsfähigkeit und Anwendbarkeit von GluonCV (Frameworks zur vereinfachten Verwendung tiefer neuronaler Netze) exemplarisch zur semantischen Segmentierung medizinischer Bilddaten mit einem U-Net. Hierzu wird angelehnt an die U-Net-Architektur [RFB15] eine vorhandene Keras-Implementierung [Pet18] in GluonCV reimplimentiert und in systematischen Versuchen verschiedene Kriterien zu Umsetzbarkeit und Performance evaluiert.

[RFB15] Ronneberger, Olaf ; Fischer, Philipp ; Brox, Thomas: U-Net: Convolutional Networks for Biomedical Image Segmentation. In: CoRR (2015).

[Pet18] Petsiuk, Vitali: Lung Segmentation (2D). (Dezember 2018). https://github.com/imlab-uiip/lung-segmentation-2d, Abruf: 05.07.2019.

Kolloqium: 05.09.2019

Gutachter: Prof. Dr. Sven Buchholz, Dipl.-Inform. Ingo Boersch

Ziel dieser Arbeit ist die Untersuchung von Ansätzen zur Stimmungsanalyse von Tweets in deutscher Sprache. Hierzu ist ein Data Mining-Prozess zu durchlaufen mit den Phasen Datenselektion, -exploration, - vorbereitung, Merkmalsgenerierung, Modellierung und Evaluation. Die besondere Schwierigkeit besteht in der Datenbeschaffung, den unstrukturierten Daten (Tweets) sowie der Auswahl und lauffähigen Umsetzung der Lernalgorithmen aus dem Bereich des Deep Learnings. Die Klassifizierer sollen mit ihren Hyperparametern nachvollziehbar dokumentiert und geeignet evaluiert werden.

Kolloqium: 29.03.2019

Betreuer: Prof. Dr. Sven Buchholz, Dipl.-Inform. Ingo Boersch

Download: A1-Poster, Masterarbeit

Beim Erlernen des Klavierspielens kann es besonders für Neueinsteiger problematisch sein, einen guten Fingersatz zu finden. Das Ziel dieser Arbeit ist, ein Programm zu erstellen, das den Fingersatz für Klavierpartituren generieren kann.

Diese Aufgabe wurde über die letzten 20 Jahre mehrfach versucht zu lösen. Die Lösungsansätze basieren meist auf der gleichen Idee und funktionieren nur bei einfachen Klavierstücken. In dieser Arbeit wurde deswegen mit einem anderen Lösungsansatz (Machine-Learning) gearbeitet. Es wurde eine Applikation zur Erzeugung von Fingersatz aus Partituren mit dem aktuellen Verfahren der bidirektionalen LSTM-Netze konzipiert und erfolgreich umgesetzt.

Die besondere Schwierigkeit lag in der Komplexität des gewählten Anwendungsszenarios und den aufwändigen Tests zur Evaluation der Performanz. Aufwändig deshalb, da es zu einer Partitur mehrere gut spielbare Fingersätze geben kann, so dass die automatisch erzeugten Fingersätze durch tatsächliches Spielen bewertet werden müssen.

Kolloqium: 28.09.2018

Betreuer: Prof. Dr. rer. nat. Martin Christof Kindsmüller, Dipl.-Inform. Ingo Boersch

Download: A1-Poster

Die Arbeit bearbeitet ein schwieriges Problem bei der automatisierten Überwachung von Pflanzenzuständen auf Bauernhöfen und Plantagen. Sie schlägt eine auf Deep Learning basierende Methode vor, um Bananenbäume auf einer Bananenplantage mittels Drohnenbildern automatisch zu detektieren und zu zählen. Die Schwierigkeit dieser Aufgabe besteht darin, dass sich Bananenbaumkronen sehr oft überlappen. Selbst für einen Menschen ist diese Aufgabe sehr schwierig zu erledigen. Die Aufgabe zerfällt damit in zwei Teile: Lokalisierung (Detektion) und Zählung.

Zur Lösung dieses Problems wird ein mehrstufiger Ansatz verwendet: ein Klassifikator erkennt, ob eine ROI eine Bananenbaumkrone enthält, ein folgender Regressor bestimmt die Koordinaten der Kronenkandidaten in der ROI. Eine abschließende Aggregation fasst die Baumkronenkandidaten zu erkannten Baumzentren zusammen. Diese sind zum Schluss die gesuchten Baumkronen. Die entwickelte Methode wird auf einem Testfall mit vielversprechenden Ergebnissen evaluiert. Auf diesem Testfall, wo dicht gepflanzte Bäume stehen, erreicht das Modell ein Margin- Of-Error von 0.0821. Dies entspricht einer Güte von 91.79% bei der Zählungsaufgabe. Hervorzuheben ist der geringe durchschnittliche Abstandsfehler von etwa 43 cm bei der Lokalisierungsaufgabe.

Kolloqium: 24.09.2018

Betreuer: Prof. Dr.-Ing. Sven Buchholz, Dipl.-Inform. Ingo Boersch, Jan Vogt (Orca Geo Services GmbH, Brandenburg)

Download: A1-Poster

Das Ziel der Arbeit ist die Untersuchung der Eignung von Hedge-Backpropagation zur Vorhersage von Maschinenausfällen auf dem Turbofan-Datensatz. Hedge-Backpropagation ist ein Multilayerperzeptron, bei dem aus jeder versteckten Schicht eine zusätzliche Ausgabe erzeugt wird. Die Ausgaben werden linear gewichtet und ihre Wichtung mit dem Hedge-Algorithmus alternierend zum übrigen Netz angepasst. So soll es möglich sein, dass sich über diese Wichtungen die genutzte Tiefe des Netzes selbständig an die Aufgabe anpasst.

Der Ansatz soll detailliert vorgestellt und entweder selbst oder unter Zuhilfenahme einer geeignet gewählten Implementierung umgesetzt und mit anderen Ansätzen, bspw. LSTM-Netzen nach sinnvoll gewählten Kriterien verglichen werden.

Kolloqium: 06.08.2018

Betreuer: Dipl.-Inform. Ingo Boersch, Prof. Dr.-Ing. Sven Buchholz, Prof. Dr. rer. nat. Adrian Paschke (Fraunhofer FOKUS)

Download: A1-Poster

Ziel der Arbeit ist die Untersuchung der Leistungsfähigkeit aktueller künstlicher neuronaler Netze zur Objektdetektion in Bildern. Hierzu sind einführend wesentliche Konzepte des Deep Learnings zu erläutern. Der Schwerpunkt der Arbeit besteht in der Evaluation regionsbasierter Objektdetektionssysteme. Hierzu soll die Funktionsweise mehrstufiger regionsbasierter Detektionssysteme, insbesondere von R-CNN, Fast-RCNN und Faster-RCNN, detailliert erläutert und verglichen werden. Die Netze sind zu implementieren und auf geeigneten Daten, bspw. den VOC-Datenmengen, zu trainieren und der Einfluss von Hyperparametern auf Rechenzeiten und Performance zu untersuchen. Die Evaluationsszenarien und Performancekriterien sind geeignet zu wählen.

Kolloqium: 11.07.2018

Betreuer: Dipl.-Inform. Ingo Boersch, Prof. Dr. Sven Buchholz

Download: A1-Poster, Masterarbeit

Ziel der Arbeit ist die Entwicklung einer Applikation zur Demonstration der Interaktion einer Person mit einem Roboter zum Erlernen von Objekten, die später wiedererkannt werden sollen. Der Schwerpunkt liegt zum einen auf der Entwicklung des Interaktionsmodells und zum anderen auf einer zuverlässigen Erkennung nach wenigen Lernbeispielen. Die besondere Schwierigkeit liegt in der Verwendung des NAO-Roboters. Die Arbeit soll die Vorarbeiten berücksichtigen und diese weiterentwickeln.

Im Ergebnis entstand eine Python-Applikation, die im Dialog mit einem Menschen in der Lage ist, Objekte zu labeln und wiederzuerkennen. Eine kreative Lösung stellt die robuste Eingabe des Labels über Stempel und Zeichenerkennung dar. Das Wiedererkennen wird durch Segemntierung und Klassifikation gelöst. Die Segmentierung erfolgt pragmatisch anhand eines initialen Hintergrundes, für die Klassifikation werden SIFT-Features als Objektmerkmale extrahiert und damit eine RBF-SVM trainiert.

Kolloqium: 07.03.2018

Betreuer: Dipl.-Inform. Ingo Boersch, Prof. Dr. Jochen Heinsohn

Download: A1-Poster

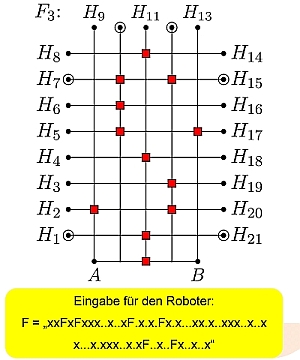

Ziel der Arbeit ist die Entwicklung einer Applikation zur Demonstration von Reinforcement- Lernen (RL) auf autonomen, humanoiden Robotern. Demonstriert werden soll das Erlernen einer erfolg- reichen Handlungsstrategie in einem einfachen realen Szenario. Das Szenario kann selbst gewählt werden, bspw. das Sortieren von Bällen. Das Szenario soll im Wesentlichen deterministisch, kann aber in seltenen Fällen stochastisch reagieren. Der Lernvorgang soll unbeaufsichtigt selbständig laufen können und in kurzer Zeit (bspw. einer Stunde) zu einer erfolgreichen Policy führen.

Ein zweiter Applikationsmodus soll das unbegrenzte Ausführen der erlernten Policy ermöglichen. Für den Lernvorgang darf der Agent keine fremderstellte Simulation verwenden, für Evaluierung und Test der Applikation ist eine Simulation natürlich erlaubt. Damit besteht die zweite Schwierigkeit in der geringen Anzahl von Interaktionen mit dem realen Szenario, so dass Maßnahmen zur Effizienzsteigerung klassischer RL-Ansätze verwendet werden müssen. Hilfreich wäre eine geeignete Visualisierung des Lernvorganges bzw. der Policy oder transparenter Wertefunktionen, um Besuchern und Studenten den Ablauf zu verdeutlichen und die Programm-Entwicklung zu unterstützen.

Kolloqium: 07.03.2018

Betreuer: Dipl.-Inform. Ingo Boersch, Prof. Dr. Jochen Heinsohn

Download: A1-Poster, Kolloquiumsvortrag, Masterarbeit

Colin Christ studiert seit 2012 Informatik an der TH Brandenburg. Den Bachelor schloss er mit dem Schwerpunkt „Intelligente Systeme“ ab. In seinem Masterprojekt vertiefte er das Thema "Reinforcement Learning (RL)" aus der Vorlesung "Künstliche Intelligenz". Reinforcement Learning ist ein Lernparadigma, das in der Robotik zunehmend Einsatz findet. Hierbei lernt ein Agent durch Ausprobieren eine genau auf seine Situation, bspw. seinen Körper und Sensorik, angepasste Handlungsstrategie. Neue Lernalgorithmen reduzieren die Anzahl notwendiger Interaktionen durch Übertragen erlebter Erfahrungen auf ähnliche Situationen und führen so zu einem verkürzten Lernvorgang. Mittlerweile scheint der Einsatz von RL in industriellen Umgebungen möglich.

Colin Christ behandelt in seiner Masterarbeit ein Szenario, in dem ein humanoider Roboter auf diese Weise vom Menschen definierte Ziele erreichen soll - ohne dass explizit programmiert wird, wie die Aufgabe gelöst werden kann: "Wünsch Dir was"-Programmierung.

Die Zwischenergebnisse präsentierte er kurzweilig und zur Diskussion anregend auf dem World Usability Day zum diesjährigen Thema "Artificial Intelligence" am 09.11.2017 im Infopanel "UX- und Design-Innovationen aus Brandenburg" in Berlin.

Ziel der Bachelorarbeit ist die Untersuchung einer medizinischen Ontologie (WNC-Ontologie*) im Hinblick auf Inkonsistenzen und die Entwicklung eines Algorithmus zur Reparatur von Inkonsistenzen. Hierzu wurden verschiedene Inkonsistenz-Dimensionen in der vorliegenden Ontologie analysiert und eine Gruppe von Inkonsistenzen definiert, für die eine Reparatur mit einem teilautomatischen Verfahren möglich ist. Dazu werden logisch widersprüchliche Bestandteile der Ontologie in einem Dialog mit dem Domänenexperten disambiguiert und anschließend korrekt modelliert.

*Die WNC-Ontologie wird von dem Berliner Unternehmen ID GmbH & Co. KGaA entwickelt. Sie bildet die in der Wingert-Terminologie dargestellten medizinischen Begriffe als Konzepte und die Zusammenhänge zwischen diesen Begriffen als Relationen ab und entstand als Ergebnis der Migration der Wissensrepräsentation aus einem semantischen Netz in eine moderne Ontologie basierend auf Beschreibungslogik.

Kolloqium: 21.09.2017

Betreuer: Prof. Dr.-Ing. Jochen Heinsohn, Dipl.-Inform. Ingo Boersch

Download: A1-Poster

Ziel der Arbeit ist die Untersuchung, ob und wie gut sich LSTM-Netze zur Prognose von Motorsignalen eignen.

LSTM-Netze sind rekurrente künstliche neuronale Netze mit einem besonderen Neuronenmodell. Diese Netze eignen sich zur Prognose (Zeitreihen, Sprachverarbeitung) oder als Generator insbesondere dann, wenn sich die relevanten Informationen in weiter Vergangenheit befinden.

Die Arbeit untersucht das Verhalten der Netze auf künstlichen Zeitreihen und auf realen Signalen im Holdout-Verfahren. Verwendet wird das Deep Learning-Framework Keras auf TensorFlow, allerdings ohne GPU-Unterstützung.

Es konnte gezeigt werden, dass LSTM in der Lage sind, dynamische Motorprozesse zu erlernen und erfolgreiche Prognosen durchzuführen. Die Prognose mit LSTM lieferte in den untersuchten Fällen in diesem ersten Pilotprojekt ohne jede Optimierung ähnlich gute Ergebnisse, wie die bereits bei IAV etablierten Modelle, ist aber im Training deutlich aufwändiger.

Kolloqium: 21.09.2017

Betreuer: Dipl.-Inform. Ingo Boersch, Prof. Dr.-Ing. Jochen Heinsohn, Dipl.-Ing. Frank Beyer (IAV GmbH)

Download: A1-Poster

Ziel der Arbeit ist ein Softwarefilter zum Entfernen der Bewegungsunschärfe in Fotos, die durch Bewegen der Kamera während der Aufnahme entstanden ist. Diese Unschärfestörung lässt sich vereinfacht als Faltung des Bildes mit einem Bewegungs-Kernel und additivem Rauschen modellieren. Gelingt es den richtigen Kernel zu finden, so kann in einer Optimierungsaufgabe das ungestörte Bild restauriert werden.

Hierzu wir in Anlehnung an ein in [Xu10] publiziertes Verfahren ein eigener vereinfachter Algorithmus entwickelt, der sich iterativ durch Herausarbeiten der Original-Kanten und Optimierung einem geeigneten Kernel nähert. Das Filter wird als Softwareprototyp in Java implementiert und als Plugin in die Bildverarbeitungssoftware Fiji eingefügt. Das Plugin soll für die Restauration von Grauwertbildern verwendet werden. Die Qualität der Restaurationsergebnisse und die Laufzeit des entstandenen Filters werden in drei Testszenarien (zwei mit bekannten Kerneln, ein reales Bild) analysiert. Das Verfahren wurde erfolgreich evaluiert.

[Xu10] Li Xu, Jiaya Jia: Two-Phase Kernel Estimation for Robust Motion Deblurring. ECCV (1) 2010: 157-170

Kolloqium: 08.08.2017

Betreuer: Prof. Dr. sc. techn. Harald Loose, Dipl.-Inform. Ingo Boersch

Download: A1-Poster

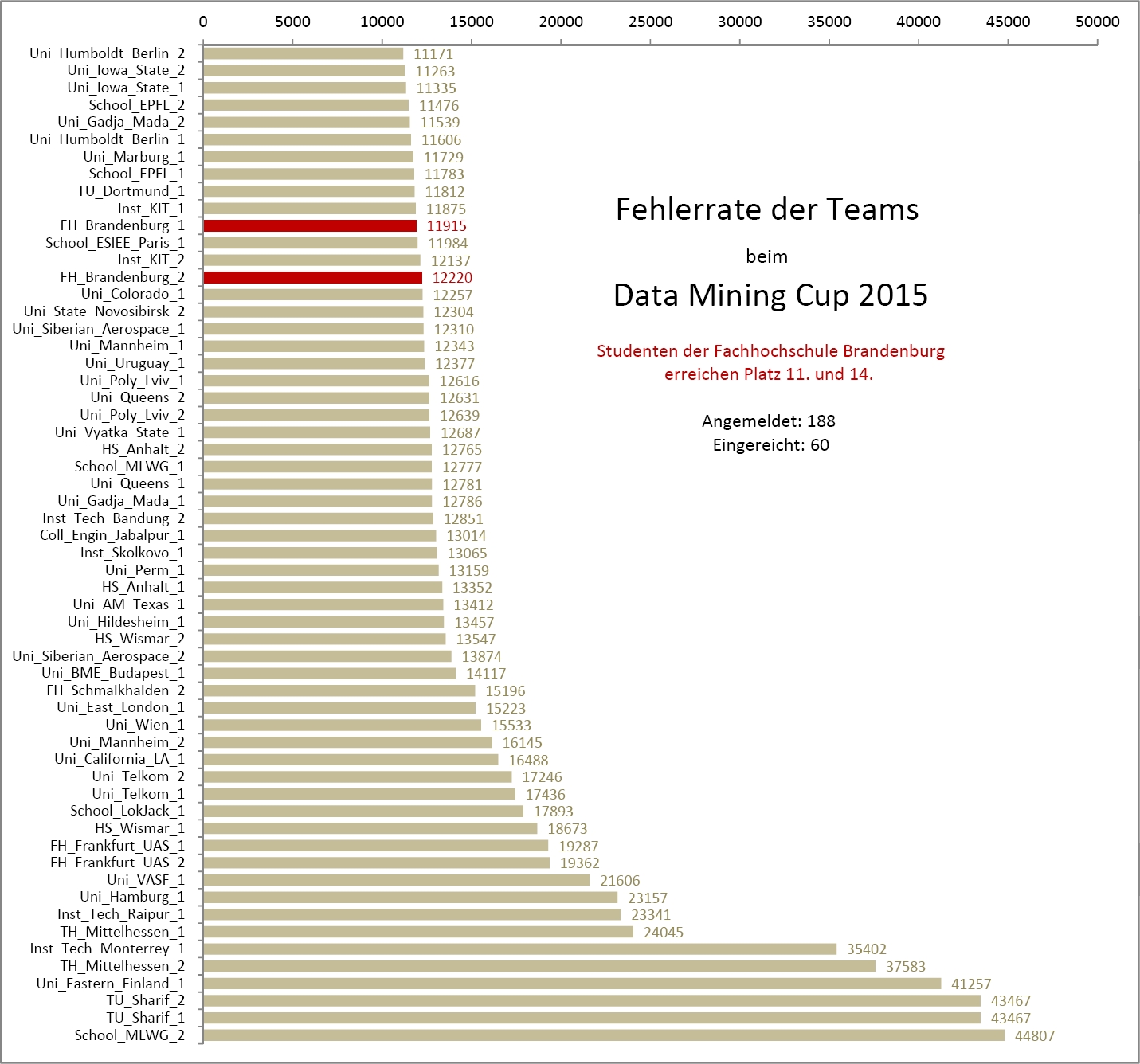

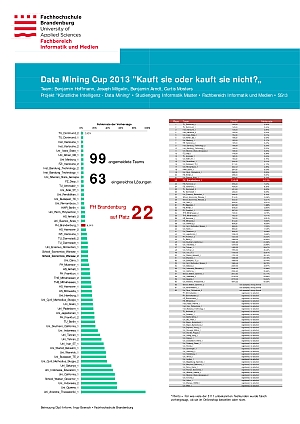

Auch in diesem Jahr beteiligten sich zwei Teams der Technischen Hochschule Brandenburg am Data Mining Cup der prudsys AG, einem Studentenwettbewerb zur intelligenten Datenanalyse. Mit 202 Hochschulen aus aller Welt erreichte die Teilnehmerzahl einen neuen Rekord. Die Aufgabe aus dem Feld "Dynamic Pricing" bestand in der Prognose einer Kundentransaktion einer Online-Apotheke. Dazu standen reale Daten über einen Zeitraum von 3 Monaten zur Verfügung, während der nachfolgende Monat vorhergesagt werden sollte.

Die Aufgabe ähnelt den Aufgaben der vergangenen Jahre, bei denen klar wurde, dass weniger die Optimierung des Lernverfahrens als insbesondere die Merkmalsgenerierung zu guten Ergebnissen beiträgt. Diese ist jedoch kaum automatisierbar und arbeitsintensiv, so dass es für die beiden Masterstudenten Mario Kaulmann und Herval Bernice Nganya Nana viel zu tun gab. Vermutlich ging es vielen Teams ähnlich, denn von den 202 Anmeldungen schafften es nur 66(!) Teams eine Lösung einzureichen, von denen aufgrund ungewöhnlicher Formatanforderungen noch 11 ungültig waren. Unter den 55 gültigen Lösungen errang das THB-Team den Platz 42, passend für Informatiker. Die zweite Einsendung erfolgte leider eine Minute zu spät und hätte Platz 38 erreicht.

Masterprojekt auf der NWK18: Der freie Wille eines Menschen ist eine urbane Hypothese und Inhalt angeregter Forschungstätigkeit. Dabei steht die Frage im Mittelpunkt, ob ein freier Wille existiert oder der Mensch durch das Unterbewusstsein gesteuert ist. Im Rahmen dieser Arbeit wird ein Experiment aus dem Bereich Mensch-Roboter-Interaktion entworfen und vorbereitet, das klären soll, ob der Mensch beim Versuch bewusst zufällig zu handeln, doch unbewusst in ein Muster verfällt. Die Voruntersuchung klärt kritische Probleme und begründet die Zuversicht in die Determiniertheit anhand der Prognose einer Zeitreihe menschlicher Aktionen.

Der Vortrag zur Publikation wird von Vanessa Vogel am 31. Mai 2017 an der Hochschule Mittweida gehalten.

Vogel, Vanessa ; Boersch, Ingo: Prognose des freien Willens - Machbarkeit und erste Ergebnisse. In: 18. Nachwuchswissenschaftlerkonferenz (NWK), Hochschule Mittweida, 2017 (Scientific Reports Nr. 1), S. 341-345. ISSN 1437-7624

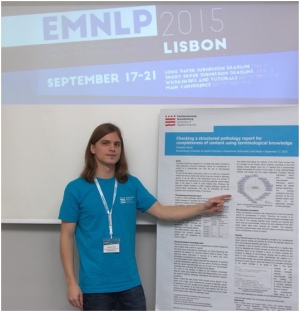

Diese Arbeit beschreibt einen Ansatz, nach dem pathologische Befundberichte strukturiert und vollständig erstellt werden können.

Die implementierte Software nutzt Vorlagen der ICCR (International Collaboration on Cancer Reporting), um ein formales Modell der drei Report-Typen zur Erstellung von Endometrium-, Haut- und Prostatakrebsbefundberichten zu erstellen. Bei den erzielten Dokument-Repräsentationen handelt es sich um Wissensbasen, welche in der Web Ontology Language (OWL) formuliert und somit nicht nur maschinenlesbar, sondern darüber hinaus maschinenverständlich sind. Durch die formal spezifizierte Semantik des entsprechenden Formats lassen sich die Berichte unter Verwendung des HermiT-Reasoners auf Vollständigkeit überprüfen. Des Weiteren wird die Verknüpfung der modellierten Report-Bestandteile zu externen medizinischen Wissensbasen wie SNOMED CT, NCIT und PathLex betrachtet.

Die Beschreibung des ontologiebasierten Verfahrens und die prototypische Implementierung des Softwaretools sollen eine mögliche Darstellungsform aufzeigen, nach der Befundberichte im Bereich der anatomischen Pathologie digital, dynamisch sowie durch vorgegebene Strukturelemente präzise und vollständig erstellt und verarbeitet werden können.

Kolloqium: 10.04.2017

Betreuer: Prof. Dr.-Ing. Jochen Heinsohn, Dipl.-Inform. Ingo Boersch

Download: A1-Poster, Masterarbeit

Ziel der Arbeit ist eine Applikation zur Menüplanung unter Verwendung ontologischen Wissens aus verschiedenen Quellen.

Ein Schwerpunkt ist die Auswahl und integrative Vernetzung geeigneter Wissensquellen in Form von Terminologien zur Beschreibung der Anforderungen an einen gewünschten Menüplan. Hierzu gehören beispielsweise Rezepte, Nährstoffangaben und diätische Restriktionen. Es soll der CTS2-Terminologieserver des Fraunhofer FOKUS verwendet werden.

Ein zweiter Schwerpunkt ist die Formalisierung des Planungsproblems sowie die Auswahl und lauffähige Umsetzung eines geeigneten Optimierungsverfahrens zur Mehrzieloptimierung. Hierbei ist der Stand der Technik einzubeziehen. Die Qualität der erstellten Pläne wird evaluiert.

Die Analyse, Konzeption und Umsetzung ermöglichen, dass aufbauend auf der Arbeit reale Planungsprobleme des Diskursbereiches gelöst werden können. Die Webapplikation läuft in einem aktuellen Browser und erlaubt in prototypischer Weise das Darstellen der Terminologien, die Eingabe des Planungsproblems, die Parametrierung der Planung und die Visualisierung der Ergebnisse. Die Schwierigkeit der Arbeit besteht in Komplexität und im Umfang der notwendig zu lösenden Teilaspekte.

Kolloqium: 24.03.2017

Betreuer: Dipl.-Inform. Ingo Boersch, Prof. Dr. rer. nat. Rolf Socher, in Kooperation mit dem Fraunhofer FOKUS

Download: A1-Poster, Masterarbeit

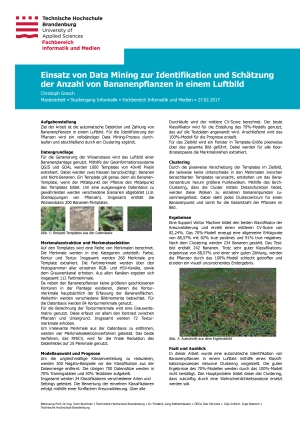

In dieser Arbeit werden in einem mit Drohnen aufgenommenen, orthorektifizierten Luftbild Bananenpflanzen detektiert und abschließend gezählt. Die Aufgabe fällt damit in das Gebiet der Mustererkennung und soll durch Ansätze des maschinellen Lernens in einem Data-Mining-Prozess gelöst werden. Die besondere Schwierigkeit besteht in der starken Überlappung der Bananenpflanzen im Bild, wodurch eine Segmentierung schwierig bis unmöglich wird. Ebenso kann bei einer entwickelten Plantage nicht mehr von einer gitterförmigen Anordnung der Pflanzen ausgegangen werden.

Ausgehend von einer Menge manuell annotierter Bananen-Templates werden Merkmale von Bildpunkten entwickelt,die es ermöglichen sollen, mit Hilfe von Supervised Learning die Zentren der Pflanzen von anderen Bildpunkten zu separieren. Es werden verschiedene Merkmale (Farbe, Textur, Gray-Level Co-Occurrence Matrix) und Lernalgorithmen systematisch untersucht.

Kolloqium: 27.02.2017

Betreuer: Prof. Dr.-Ing. Sven Buchholz , Dr. Frederik Jung-Rothenhäusler (ORCA Geo Services), Dipl.-Inform. Ingo Boersch

Download: A1-Poster

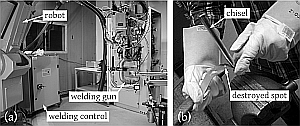

Beim Widerstandspunktschweißen werden dünne Bleche durch hohe Ströme im Kiloampere-Bereich punktuell miteinander verschweißt. Haupteinsatzgebiet des Fügeverfahrens sind Kraft- und Schienenfahrzeugbau, bei denen diese Verbindungen sicherheitskritischen Anforderungen genügen müssen. Trotz intensiver Forschung auf dem Gebiet ist kein hinreichend zuverlässiges Verfahren bekannt, die Güte der Schweißverbindung zerstörungsfrei zu bestimmen.

Da die Güte der Verbindung wesentlich durch den Verschleiß der Elektrodenkappen mitbestimmt wird, werden die Elektroden mit einem großen Sicherheitspuffer nachgefräst oder gewechselt. Wir stellen einen Ansatz vor, wie ein wesentliches Qualitätsmerkmal - der Punktdurchmesser - mit Prognoseverfahren anhand von Prozessgrößen hinreichend zuverlässig geschätzt und so die Elektrodenlebensdauer erhöht werden kann.

Ziel der Arbeit ist eine Untersuchung numerischer und strategischer Parameter bei der Anwendung von Autoencodern zur Erkennung von Anomalien in Bildern. Hierbei sind systematisch die Einflüsse verschiedener Einstellungen zu evaluieren und zu bewerten. Im Ergebnis soll eine Empfehlung zur Einstellung des Verfahrens bei der Detektion Malaria-infizierter Blutzellen vorgenommen werden. Die besondere Schwierigkeit der Arbeit besteht in der Umsetzung eines systematischen Suchprozesses in einem umfangreichen Parameterraum, der Arbeit mit realen Daten und dem aufwändigen Training.

Kolloqium: 14.10.2016

Betreuer: Dipl.-Inform. Ingo Boersch, Prof. Dr.-Ing. Sven Buchholz, Dr.-Ing. Christian Wojek (Carl Zeiss AG)

Download: A1-Poster

Ziel der Arbeit ist die Entwicklung einer Applikation, die einem NAO-Roboter ermöglicht, autonom Tic- Tac-Toe gegen einen menschlichen Spieler zu spielen. Schwerpunkt ist hierbei ein natürliches und motivierendes Spielerlebnis. Hierzu ist es notwendig, robuste Lösungen für Teilprobleme der Interaktion wie Rezeption und Aktorik zu entwickeln, die diese Zielstellung berücksichtigen. Eine leistungsfähige Spielstrategie ist so umzusetzen, dass sowohl starke wie auch schwächere Spieler Freude an der Interaktion finden. Die Applikation soll autonom auf dem Roboter laufen und perspektivisch für andere Spiele sowie beim Spiel NAO gegen NAO einsetzbar sein. Die besondere Schwierigkeit der Arbeit liegt in der Gestaltung der Interaktion und dem Lösen der Robotik-Probleme in einer realen, stochastischen Welt.

Die Arbeit wurde in die Problemfelder Spiellogik, Strategie, Aktorik, Bildverarbeitung und Interaktion aufgeteilt. Spiellogik und Strategie beschäftigen sich mit der Umsetzung des grundlegenden Spielablaufs. Die Aktorik dient primär der Umsetzung des Zeichnens auf dem Spielfeld. In der Bildverarbeitung wird das Spielfeld mit Hilfe der Roboterkameras erfasst und ausgewertet. In der Interaktion wird eine auf Sprache basierende Schnittstelle mit dem menschlichen Gegenspieler sowie eine adaptive Spielstärke umgesetzt.

Kolloqium: 02.08.2016

Betreuer: Prof. Dr.-Ing. Jochen Heinsohn, Dipl.-Inform. Ingo Boersch

Download: A1-Poster

Ziel der Arbeit ist das Erstellen gültiger, transparenter, prädiktiver Modelle zur Vorhersage patientenorientierter Zielgrößen (poZg), wie bspw. dem Überleben von Brustkrebspatientinnen, aus den Daten des Tumorzentrums. Die Analyse dient insbesondere dem Aufzeigen bisher unbekannter Zusammenhänge, Einflussgrößen und Mustern, die zur Verbesserung des Behandlungsprozesses dienen können und mit Ärzten diskutiert werden können. Die Ergebnisse sind in ihrer Güte anhand der vorliegenden Daten geeignet zu bewerten und durch Fachexperten (Ärzte, TZBB) zu evaluieren.

Zugehörige Aufgabenstellungen sind unter anderem: Definition patientenorientierter Zielgrößen, deskriptive und explorative Analyse, Bestimmung relevanter Merkmale, Merkmalsdefinition, Modellbildung und Evaluierung.

Ein zweiter Schwerpunkt ist die geeignete patientenorientierte Visualisierung von Zusammenhängen, die bei Entscheidungen des Patienten hilfreich sein können. Besondere Schwierigkeiten der Arbeit sind die Umsetzung des Data Mining Prozesses mit realen, unvollständigen, fehlerbehafteten Daten und die Nutzung transparenter Modellierung und Visualisierung zum Erkenntnisgewinn für Fachexperten und zur Entscheidungsunterstützung für Patienten. Alle Softwaremodule sollen auf Wiederverwendbarkeit, auch durch Anwender beim TZBB, ausgelegt sein, vorzugsweise soll Python verwendet werden.

Kolloqium: 13.06.2016

Betreuer: Dipl.-Inform. Ingo Boersch, Prof. Dr.-Ing. Sven Buchholz

Download: A1-Poster

Masterstudent Patrick Rutter demonstrierte am 1. juni bei der Projektkonferenz der THB, die Fähgikeiten des von ihm programmierten NAO-Roboters beim TicTacToe-Spiel gegen Besucher. Mithilfe eines verlängerten Fingers setzt der NAO auf einen Touchscreen sein Feld und erkennt die Züge des Menschen. Während des Spieles versucht er zwar zu gewinnen, aber nicht demotivierend oft. Er adaptiert sich dazu an die Spielstärke des menschlichen Spielers und erzeugt so ein kurzweiliges Spielerlebnis.

Die Präsentation zeigt einen Zwischenstand der Masterarbeit.

Vom 19. bis 21. Mai trafen sich Professoren, Mitarbeiter und Studenten norddeutscher Fachhochschulen zum zwanglosen Austausch über Forschung und Lehre beim 21. Norddeutschen Kolloquium für Informatik an Fachhochschulen (NKIF 2016) an der HAW Hamburg. Für die TH Brandenburg stellte Franziska Krebs (Masterstudentin Informatik) ihre Zwischenergebnisse zum SmartMenu-Projekt vor, in dem eine Speiseplanung gestützt auf Ontologien und semantische Technologien vorgenommen wird.

Vortragsfolien: Aufbau eines Wissensnetzes für ein klinisches Speiseempfehlungssystem – ein Beispiel aus dem THB-Forschungs-/Projektstudium

Es wurden Kontakte geschlossen und aufgefrischt, gefachsimpelt und diskutiert.

Ziel der Arbeit ist Reflektion und Analyse der Therapieentscheidung im realen Behandlungsprozess des Mammakarzinoms. Dafür soll zunächst ein normatives Modell, welches aus der S3-Leitlinie (LL) gewonnen wird, mit den tatsächlichen Gegebenheiten, gegeben durch epidemiologische Daten des Tumorzentrums Land Brandenburg e.V., verglichen werden.